浅析HDFS分布式存储有哪些优势特点

近年,随着区块链、大数据等技术的推动,全球数据量正在无限制地扩展和增加。分布式存储的兴起与互联网的发展密不可分,互联网公司由于其大数据、轻资产的特点,通常使用大规模分布式存储系统。

那么分布式存储的种类有哪些呢?

分布式存储包含的种类繁多,除了传统意义上的分布式文件系统、分布式块存储和分布式对象存储外,还包括分布式数据库和分布式缓存等,但其中架构无外乎于三种:

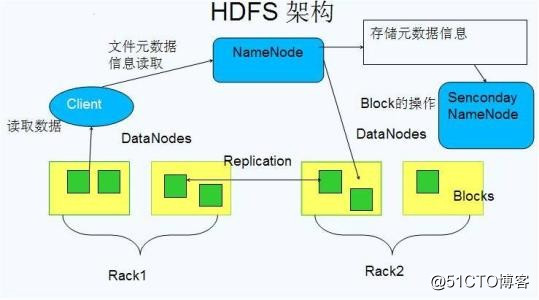

A、中间控制节点架构 - 以 HDFS 为代表的架构是典型的代表

B、完全无中心架构 – 计算模式,以 Ceph 为代表的架构是其典型的代表

C、完全无中心架构 – 一致性哈希,以 swift 为代表的架构是其典型的代表

这里我们主要HDFS有哪些优势

HDFS(Hadoop Distributed File System)是hadoop项目的核心子项目,是分布式计算中数据存储管理的基础。是基于流数据模式访问和处理超大文件的需求而开发的, 可以运行于廉价的商用服务器上。

它所具有的高容错、 高可靠性、 高可扩展性、 高获得性、 高吞吐率等特征为海量数据提供了不怕故障的存储, 为超大数据集(Large Data Set) 的应用处理带来了很多便利。

HDFS是开源的,存储着Hadoop应用将要处理的数据,类似于普通的Unix和linux文件系统,不同的是它是实现了google的GFS文件系统的思想,是适用于大规模分布式数据处理相关应用的、可扩展的分布式文件系统。

HDFS的特点

1、海量数据存储: HDFS可横向扩展,其存储的文件可以支持PB级别或更高级别的数据存储。

2、高容错性:数据保存多个副本,副本丢失后自动恢复。可构建在廉价的机器上,实现线性扩展。当集群增加新节点之后,namenode也可以感知,进行负载均衡,将数据分发和备份数据均衡到新的节点上。

3、商用硬件:Hadoop并不需要运行在昂贵且高可靠的硬件上。它是设计运行在商用硬件(廉价商业硬件)的集群上的。

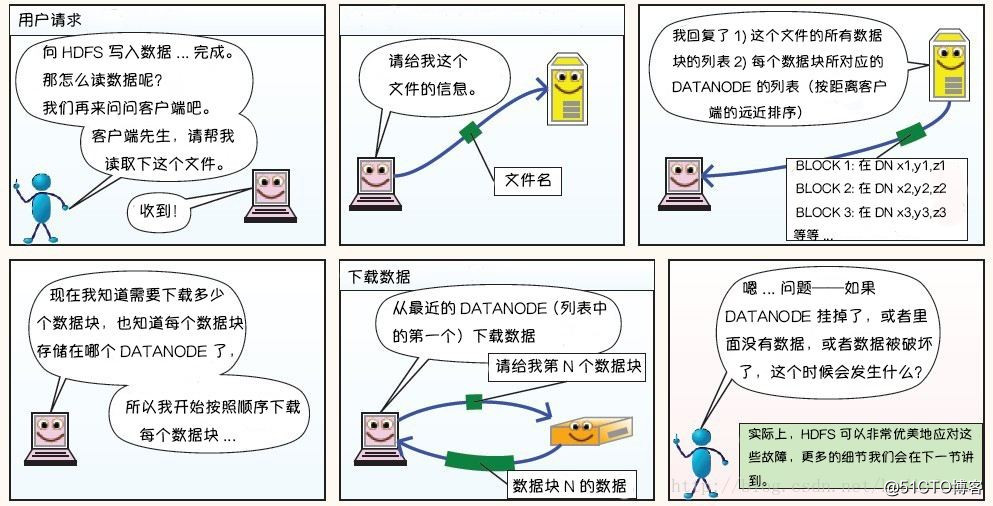

4、大文件存储:HDFS采用数据块的方式存储数据,将数据物理切分成多个小的数据块。所以再大的数据,切分后,大数据变成了很多小数据。用户读取时,重新将多个小数据块拼接起来。

5、检测和快速应对硬件故障:在集群环境中,硬件故障是常见性问题。因为有上千台服务器连在一起,故障率很高,因此故障检测和自动恢复hdfs文件系统的一个设计目标。假设某一个datanode挂掉之后,因为数据是有备份的,还可以从其他节点里找到。namenode通过心跳机制来检测datanode是否还存活。

6、流式数据访问:(HDFS不能做到低延迟的数据访问,但是HDFS的吞吐量大)=》Hadoop适用于处理离线数据,不适合处理实时数据。HDFS的数据处理规模比较大,应用一次需要大量的数据,同时这些应用一般都是批量处理,而不是用户交互式处理。应用程序能以流的形式访问数据库。主要的是数据的吞吐量,而不是访问速度。访问速度最终是要受制于网络和磁盘的速度,机器节点再多,也不能突破物理的局限。

HDFS-硬盘文件分布式公链

HDFS结合了区块链的机制,保证了通讯安全,加入门槛低廉,文件和数据可以真正落地,不像市场那些IPFS,只能币流通,无法应用落地。我们将会直接改变未来,改变生态使用。

技术突破壁垒,降低资源损耗,为市场做出贡献,为世界做出改变。

HDFS亮点:

1、廉价的硬盘存储计算机和相关设备均可以加入成为节点,HDFS是一个高度容错性的系统,适合部署在廉价的机器上。HDFS能提供高吞吐量的数据访问,非常适合大规模数据集上的应用。所以只需要你加入节点作为贡献,就能得到奖励机制。

2、数据的容错和恢复机制,满足大于N+3保证数据完整性。

HDFS设计成能可靠地在集群中大量机器之间存储大量的文件,它以块序列的形式存储文件。文件中除了最后一个块,其他块都有相同的大小。属于文件的块为了故障容错而被复制。当他的节点超过3台以上即便有节点损坏,或者关机都不影响文件的丢失和安全,不像IPFS当节点关机文件也不存在了!

3、通讯协议,安全隐秘。所有的节点都是主动点对点P2P,融合区块链特性和机制。

P2P是一种分布式网络,网络的参与者共享他们所拥有的一部分硬件资源(处理能力、存储能力、网络连接能力、打印机等),这些共享资源需要由网络提供服务和内容,能被其它对等节点(peer)直接访问而无需经过中间实体。在此网络中的参与者既是资源(服务和内容)提供者(server),又是资源(服务和内容)获取者(client)

RPC(Remote Procedure Call)抽象地封装了Client Protocol和DataNode Protocol协议。按照设计,名字节点不会主动发起一个RPC,它只是被动地对数据节点和客户端发起的RPC作出反馈。

4、数据正确性

从数据节点上取一个文件块有可能是坏块,坏块的出现可能是存储设备错误,网络错误或者软件的漏洞。HDFS客户端实现了HDFS文件内容的校验。当一个客户端创建一个HDFS文件时,它会为每一个文件块计算一个校验码并将校验码存储在同一个HDFS命名空间下一个单独的隐藏文件中。当客户端访问这个文件时,它根据对应的校验文件来验证从数据节点接收到的数据。

基于HDFS存储生态构建:

HDFS作为下一代个人数据存储的承载着,基本面是负责将数据安全、有效的记录到网上另一方面则是以庞大的个人数据为一套延伸出更多的基于数据之上的服务,帮助用户将个人数据充分利用起来,服务于用户自身。

1)、数据直接利用

01、AI智能健康检测:接入AI 体系,在经过用户授权之后能够实对用户个人数据中与健康有关的数据进行终身的跟踪分析预判,帮助用户找出潜在的健康威胁能够作为医院临床诊断的重要依据,建立普及全民的个人终身健康数据档案。

02、办公助手:对个人数据中办公相关的文件进行整理,帮助用户提升办公效率引入链上办公工具,能够在线实时编辑更新文件。

03、个人消费偏好推荐:通过用户的个人消费偏好的识别,可以有针对性的为用户在全网搜寻符合用户的消费喜好的商品提升生活的便捷性。

2)、数据的脱敏再利用

充分发挥数据的价值,不仅仅是服务于个人,在数据经过脱敏之后,隐藏掉个人数据的信息以及数据涉及到的敏感内容之后,可以选择将数据提交给大数据中心以及AI智能大脑的训练之中,彻底发挥数据最大的价值最后更好的服务于每一个用户的日常生活之中。

3)、基于个人数据之上信用体系

基于个人行为数据,金融授信单位有更加充分的数据给到用户进行授信,将来每个人都能有基于个人行为的金融授信额度,可能带来一场个人征信与金融行业的重大革命。

对于个人可信数据的利用还在不断的开发当中,HDFS最大的价值就在于为个人数据打造了一个安全、可信的载体并且设计了授权调用的机制用户可以基于个人意愿授予第三方有限的数据调用全线,从个人数据到大数据之间形成一个闭环的体系。

以上就是本篇文章的全部内容,更多详细信息敬请关注。

来源:oschina

链接:https://my.oschina.net/u/4267970/blog/4470164