Abstract

基于草图的图像检索(SBIR)是给定手绘草图,从自然图像数据库中检索图像的任务。现有的评价方法主要关注粗粒度的检索,即检索与草图属于同一个类别的图像,而不一定具有与草图相同的形状特征。而这导致现有方法只是简单地学习如何将草图与seen class联系起来,而无法推广到unseen class。因此,本文提出zero-shot SBIR,在unseen class上评价模型性能。并且,通过实验证明了现有的SBIR方法(基于判别式方法训练)只能学习到sketch-image到类别的映射关系(class specific mappings),无法推广到zero-shot场景。为了避免这种情况,提出生成式方法(基于Variational Autoencoders和Adversarial Autoencoders的深度条件生成模型),将草图作为输入,并随机填充缺失信息(通过生成草图中缺失的信息来检索相似图像)。

Motivations

1、基于视觉描述的图像检索(以图搜图)比基于文本的图像检索(以文搜图)具有更强的表达能力,而视觉描述不仅指自然图像,也可以是手绘草图(当自然图像难以获得时,用户可以在触屏设备上简单手绘草图)。SBIR的主要挑战是image和sketch之间的domain gap,sketch只有物体的轮廓,与image相比只有很少的信息。另外,sketch的类内方差大,因为人们在绘制草图时会有不同程度的抽象。因此,为了更好的泛化能力,SBIR模型需要能挖掘sketch和image之间的对齐关系。

2、但是由于现有的评价方法只是关注类别粒度的检索,而不是形状或属性检索,导致SBIR模型只需要学习sketch到label的映射就能达到较好的性能。基于细粒度的评价方法能缓解此问题,但是它依赖人工标注排序,人力成本高而且会受到主观影响。所以提出在zero-shot场景下的粗粒度检索作为细粒度检索的替代,来避免上述问题。为了达到较好的性能,ZS-SBIR模型需要学会将sketch和image的潜在对齐关系联系起来。而且ZS-SBIR更符合实际场景,模型训练时不可能囊括所有类别。

Limitations of existing SBIR methods

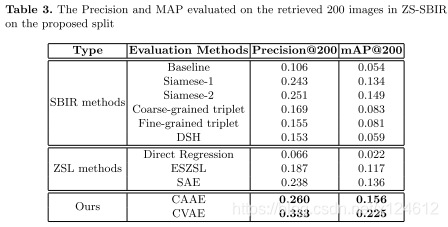

比较了三种state-of-the-art SBIR方法,分别是Siamese Network、Triplet Network、Deep Sketch Hashing(DSH)。

这些模型的性能显著下降,表明现有SBIR方法的泛化性很差。可能是因为模型在判别式场景下训练,只学习sketch和image到label的映射。Siamese network表现最好,triplet network次之,可能因为只有60000张左右图像,训练不够充分。而且粗粒度的triplet network表现比细粒度好,可能因为细粒度训练难度更大。此外,DSH表现最差,可能因为semantic factorization loss只考虑训练集的类别标签向量,并没有缓解测试集上的semantic gap。

Generative Models for ZS-SBIR

提出利用生成模型来解决ZS-SBIR问题,动机是当sketch给出了image的基本轮廓时,通过生成模型,可以从潜在的先验变量Z中产生额外细节信息。由于我们没有给出类别标签信息,希望模型能够学会将草图的轮廓、局部形状等特征与图像的相应特征联系起来。

生成模型:Gθ = P(ximg|xsketch;θ)

Let Gθ model the probability distribution of the image features (ximg) conditioned on the sketch features (xsketch) and parameterized by θ

Variational Autoencoders

VAE :

P(X)的变分下界:p是真实分布,q是高斯概率分布来逼近

Conditional VAE:

In this work, we model the probability distribution over images conditioned on the sketch i.e P(ximg|xsketch)

此外,为了保留sketch的潜在对齐关系,在目标函数加入重建regularization loss

Adversarial Autoencoders

encoder-decoder要最小化损失:

判别器D要最大化损失:

同样在encoder-decoder加入上述重建regularization loss

Experiments

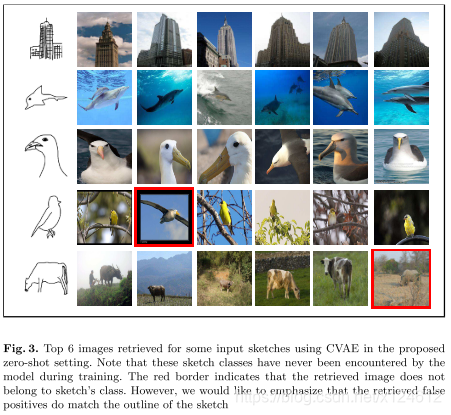

我们的方法性能最好,CVAE比CAAE更好,可能由于CAAE的对抗模型训练不稳定,使用reconstruction loss能带来precision的3%的提高。SAE性能也不错,它是将sketch映射到image,一张给定的sketch对应一个生成的image,与我们的方法类似,不同的是,对于一张给定的sketch,我们从潜在分布中采样一组Z,来生成一组image(检索时取聚类中心代表这张sketch,计算余弦距离),填充缺失信息。

而对于误报的image,虽然与sketch类别不同,但是有很相似的轮廓。

Conclusion

指出判别式方法在zero-shot场景下的不足,提出生成模型的方法,值得借鉴

zero-shot learning主流的方法分为 embedding based(词向量、属性等)和generative based approaches

来源:51CTO

作者:x124612

链接:https://blog.csdn.net/x124612/article/details/100182668