喜欢我们,点击上方AINLPer,关注一下,极品干货即刻送达!

引言

微信下载论文不方便,你可以直接回复:QA009 进行打包下载。

资料整理不易,最后帮作者点个赞、点个在看吧,谢谢~~

往期QA系列论文:

正文开始

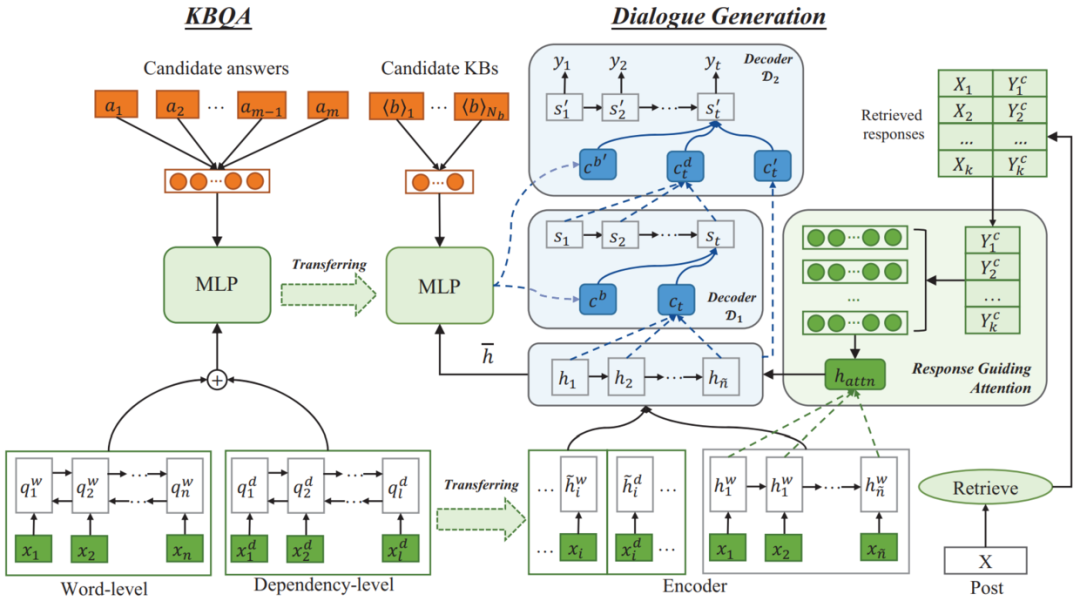

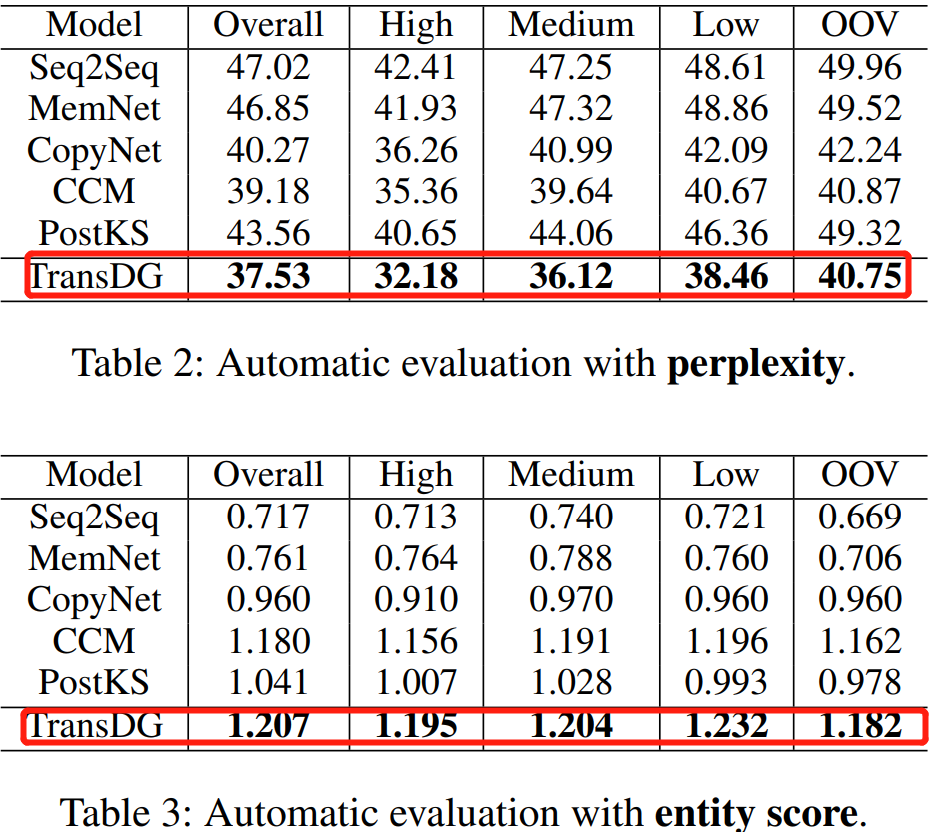

1、TILE: Improving Knowledge-aware Dialogue Generation via Knowledge Base Question Answering

Author: Jian Wang • Junhao Liu • Wei Bi

Paper: https://arxiv.org/pdf/1912.07491v1.pdf

Code: https://github.com/siat-nlp/TransDG

论文简述: 神经网络模型通常面临将常识纳入开放对话系统的挑战,本文提出了一种新的基于知识的对话生成模型,该模型将问题表示和知识匹配从知识库问答任务中转移出来,以促进对话生成过程中的话语理解和事实知识的选择。此外,本文还提出了结果导向注意和多步解码策略,以引导我们的模型专注于相关的特征来产生结果。在两个基准数据集上的实验表明,本文提出的模型在生成信息丰富、对话流畅方面具有较强的鲁棒性。

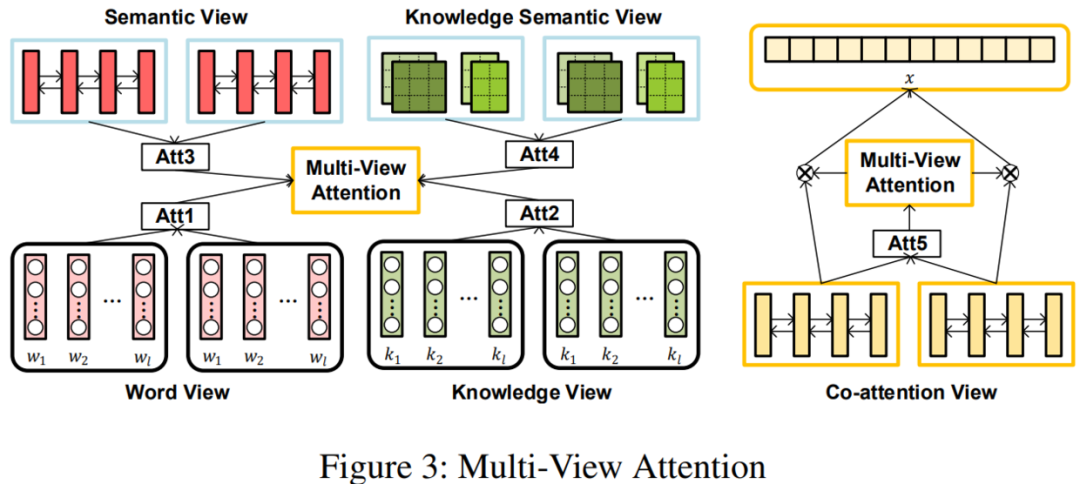

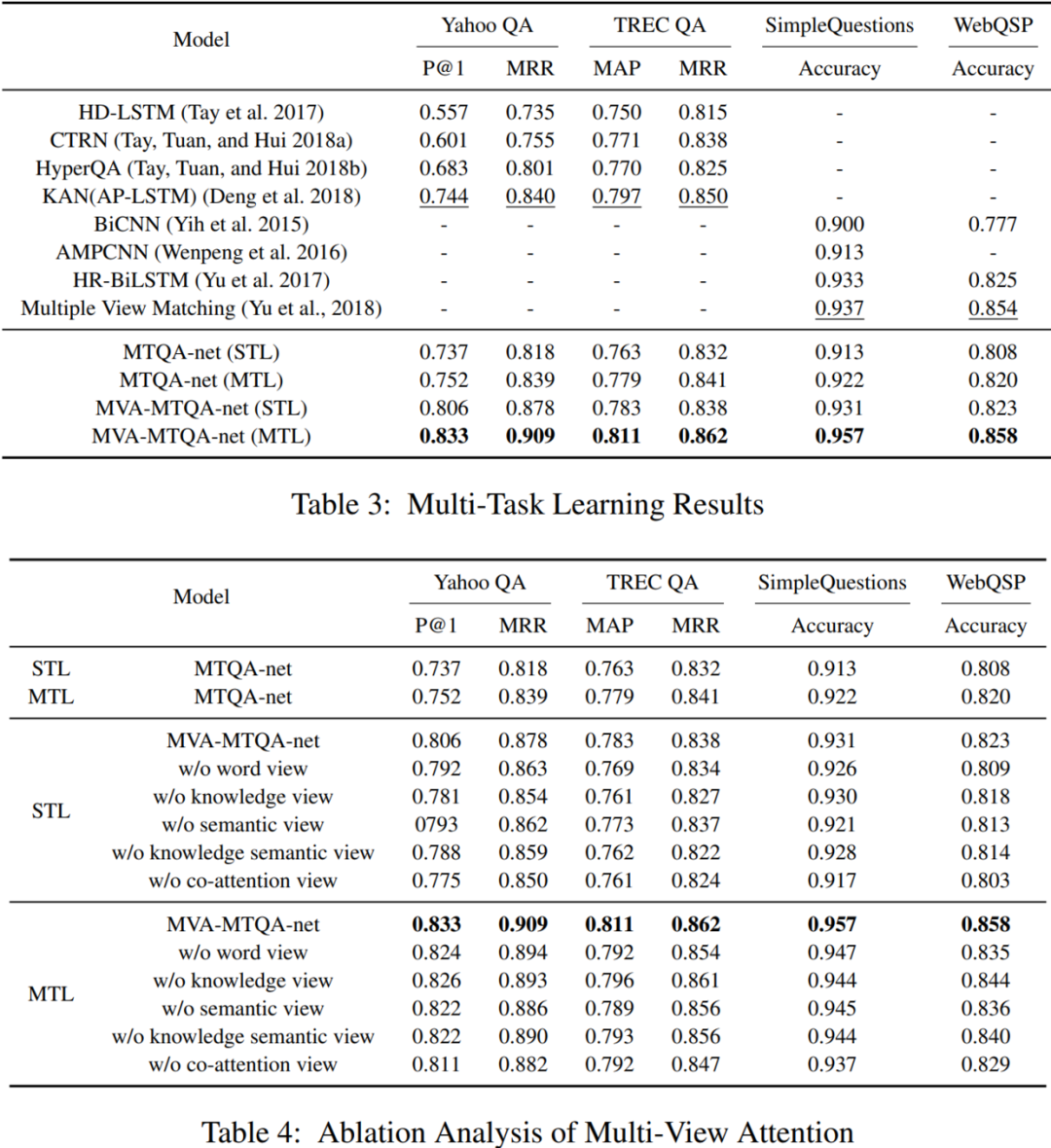

2、TILE: Multi-Task Learning with Multi-View Attention for Answer Selection and Knowledge Base Question Answering

Author: Yang Deng • Yuexiang Xie • Yaliang Li

Paper: https://arxiv.org/pdf/1812.02354v1.pdf

Code: https://github.com/dengyang17/MTQA

论文简述: 答案选择和知识库问答(KBQA)是问答系统的两项重要任务。现有的方法是分别解决这两个任务,这需要大量的重复工作,并且忽略了任务之间丰富的关联信息。在本文中,我们通过多任务学习(MTL)同时处理答案选择和KBQA任务。其主要处理流程为:首先,答案选择和KBQA都可以看作是一个排序问题,一个在文本层面,一个在知识层面。其次,这两个任务可以互利共益:答案选择可以包含知识库的外部知识,而KBQA可以通过从答案选择中学习上下文信息来。为了实现共同学习这两个任务的目标,我们提出了一种新的多任务学习方案,从不同角度学习多视角注意,使这些任务相互作用,学习更全面的句子表征。实验证明,多视图注意力方案可以有效地从不同的表示角度组合注意力信息,提高了答案选择和KBQA的性能。

3、TILE: RuBQ: A Russian Dataset for Question Answering over Wikidata

Author: Vladislav Korablinov • Pavel Braslavski

Paper: https://arxiv.org/pdf/2005.10659v1.pdf

Code: https://github.com/vladislavneon/RuBQ

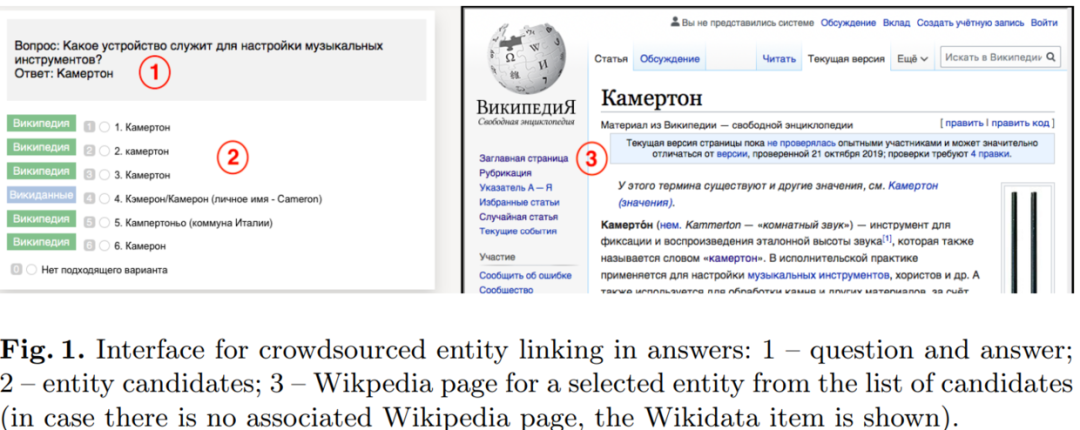

论文简述: 本文介绍了RuBQ,这是俄罗斯第一个知识库问答(KBQA)数据集。高质量的数据集包括1,500个复杂程度不同的俄语问题,英语机器翻译,对Wikidata的SPARQL查询,参考答案以及包含带有俄语标签的实体Wikidata样本(三元组)。数据集的创建始于大量来自在线测验的问答对, 数据经过自动过滤,人群辅助实体链接,SPARQL查询的自动生成以及随后的内部验证。

4、TILE: AMUSE:Multilingual Semantic Parsing for Question Answering over Linked Data

Author: Sherzod Hakimov • Soufian Jebbara • Philipp Cimiano

Paper: https://arxiv.org/pdf/1802.09296v1.pdf

Code: https://github.com/ag-sc/AMUSE

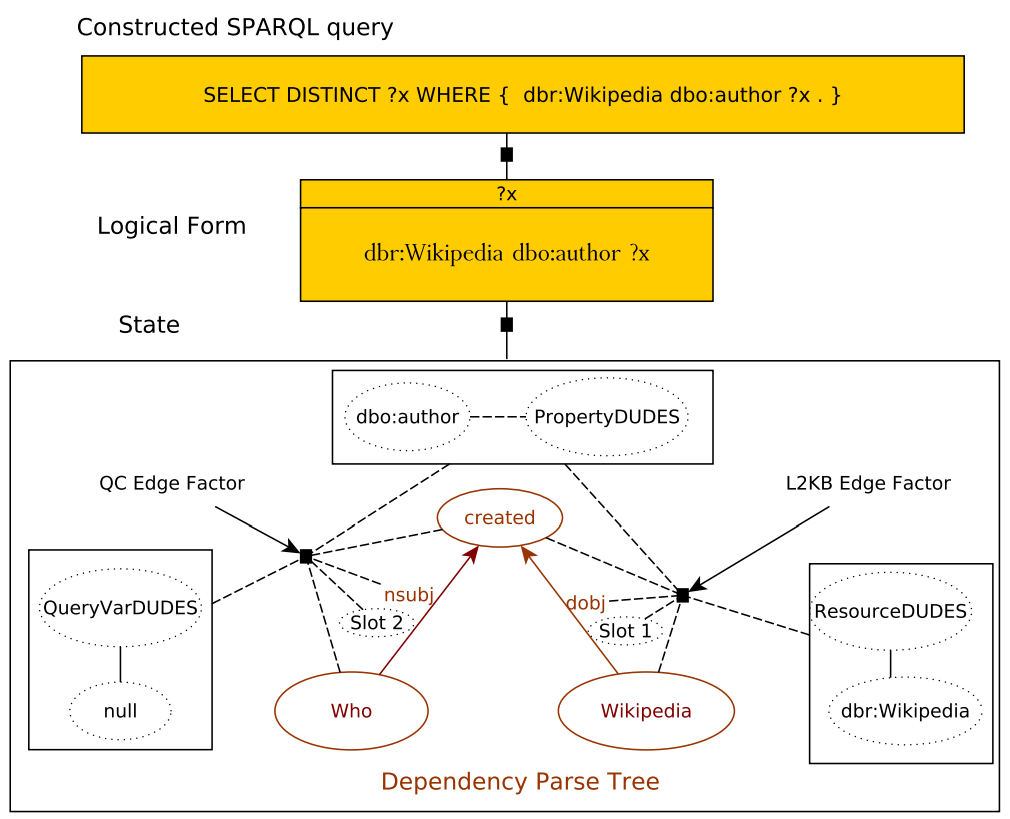

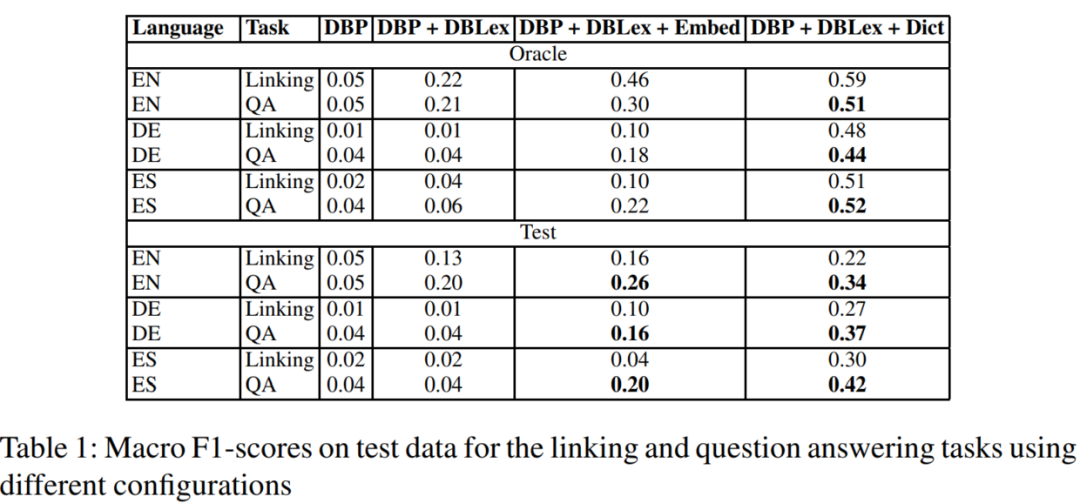

论文简述: 近年来,在RDF数据上实现自然语言问答任务吸引了很多研究者的兴趣,特别是在一系列QALD基准的上下文中。这类任务将一个自然语言问题映射到一个可执行的表单,例如SPARQL,这样就可以从给定的知识库中提取答案。到目前为止,提出的大多数解决方案是单语的,且并依赖一组硬编码规则来解释问题,最后将它们映射到SPARQL查询中。本文提出了第一个多语言QALD管道,它从训练数据中归纳出一个模型,用于将自然语言问题映射为概率逻辑形式。本文方法学会了将通用语法依赖表示映射到基于DUDES的语言无关逻辑形式,然后将DUDES映射到SPARQL查询。我们的模型建立在因子图上,依赖于从关系图中提取的特征和相应的语义表示。我们依赖近似推断技术,特别是Markov Chain Monte Carlo方法,以及Sample Rank实现目标排序和参数更新。本文重点在于方法开发,为了克服词汇差距,还提出了一个新的组合机器翻译和字嵌入方法。

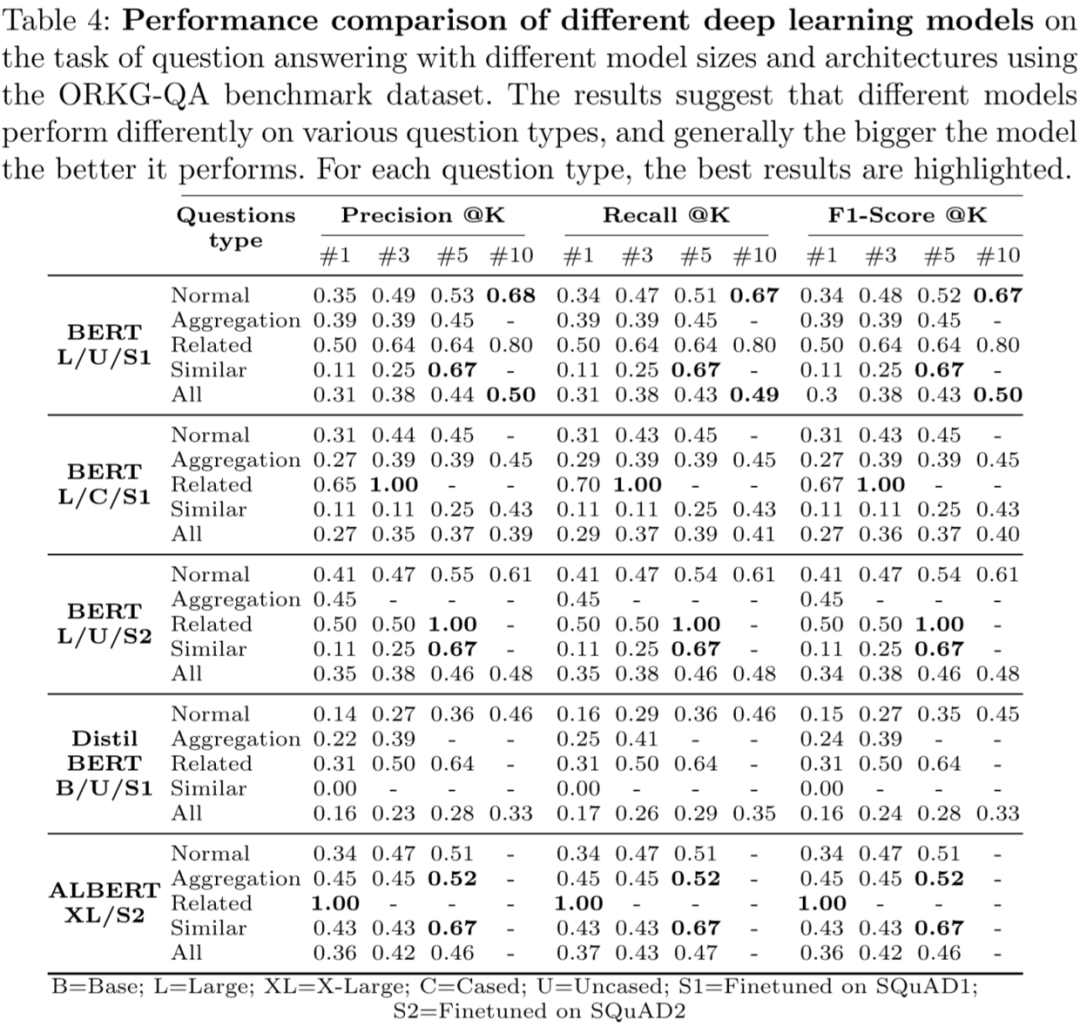

5、TILE: Question Answering on Scholarly Knowledge Graphs

Author: Mohamad Yaser Jaradeh • Markus Stocker

Paper: https://arxiv.org/pdf/2006.01527v1.pdf

Code: None

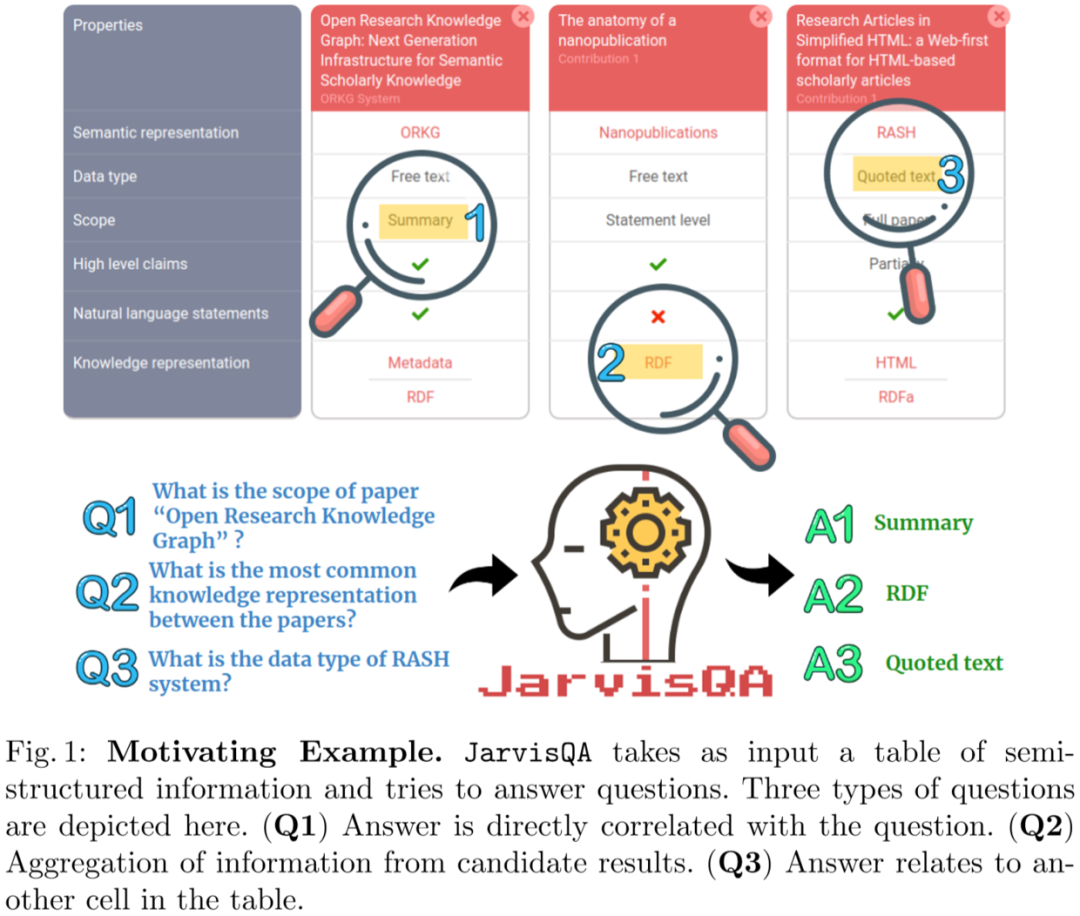

论文简述: 回答包含文本和人造学术知识问题是学术研究的重要组成部分。查询学术知识和检索合适的答案目前几乎不可能,其主要原因是:在发表的文章中包括机器无法操作、模棱两可和结构化的内容。为此本文提出了一个基于BERT的JarvisQA系统,该系统可以检索文章中表格数据中提出的各种不同问题的直接答案。JarvisQA在两个数据集上与其他基线进行了比较,与相关方法相比,JarvisQA的性能提高了两到三倍。

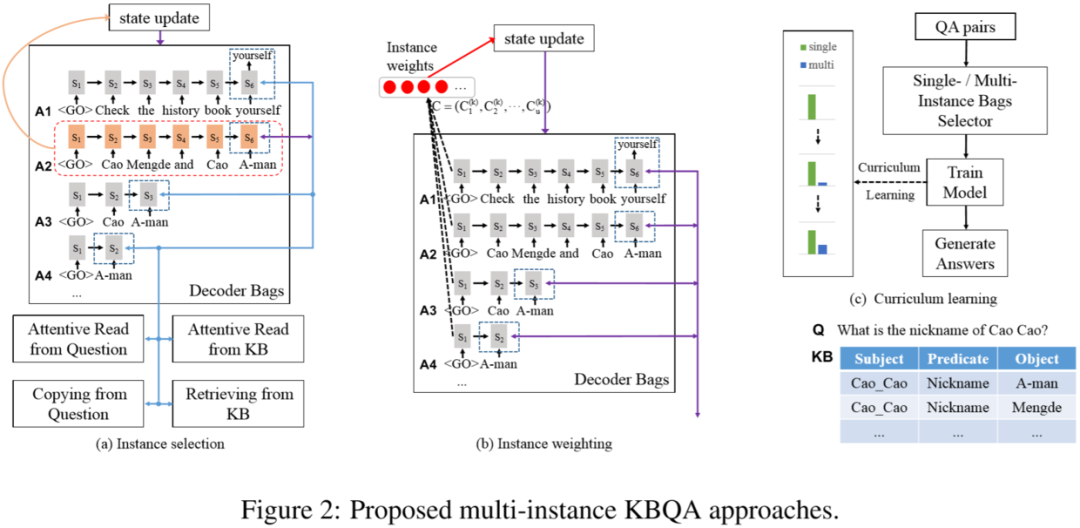

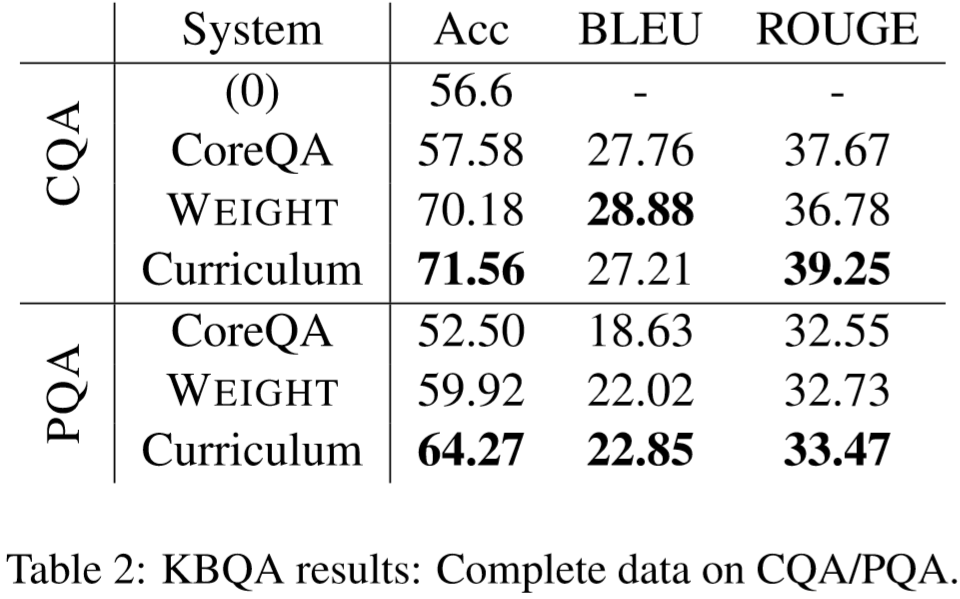

6、TILE: Multi-Instance Learning for End-to-End Knowledge Base Question Answering

Author: Mengxi Wei • Yifan He

Paper: https://arxiv.org/pdf/1903.02652v1.pdf

Code: None

论文简述: 端到端训练已经成为实现知识库问答(KBQA)的流行方法。然而,真实的应用通常包含针对用户问题的不同质量的答案,平等地处理用户问题的所有可用答案是不恰当的。本文提出了一种基于多实例学习的新方法,通过探索训练端到端KBQA模型中相同问题的答案之间的一致性来解决有噪声答案的问题。在公共CQA数据集上,本文方法显著提高了实体精度和Rouge-L得分,超过了最先进的端到端KBQA基线。

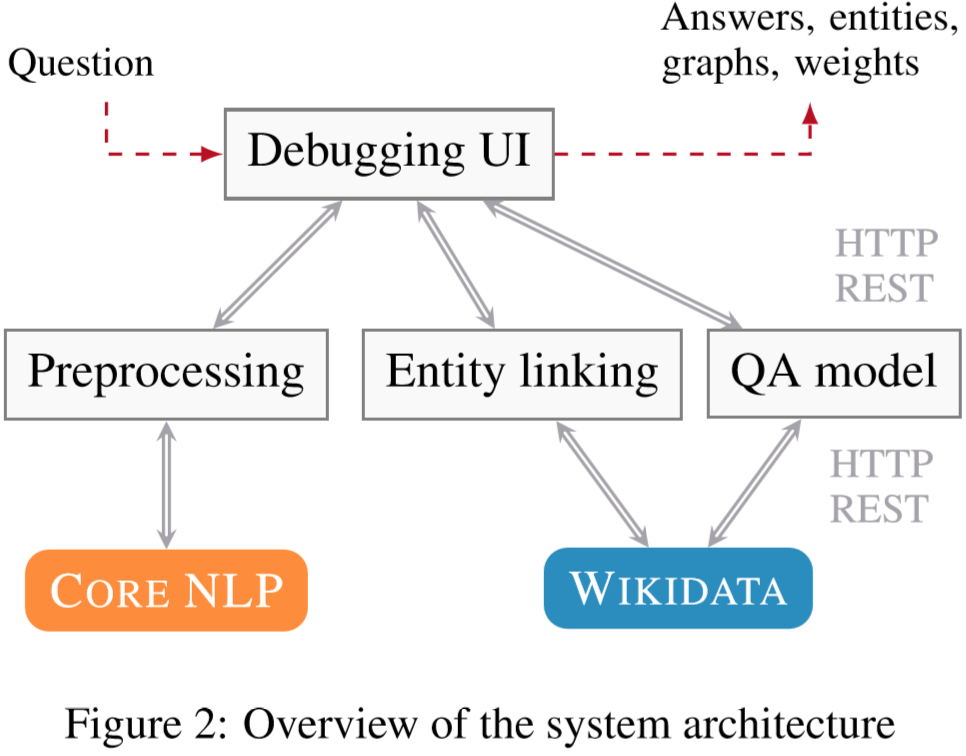

7、TILE: Interactive Instance-based Evaluation of Knowledge Base Question Answering

Author: Daniil Sorokin • Iryna Gurevych

Paper: https://www.aclweb.org/anthology/D18-2020.pdf

Code: None

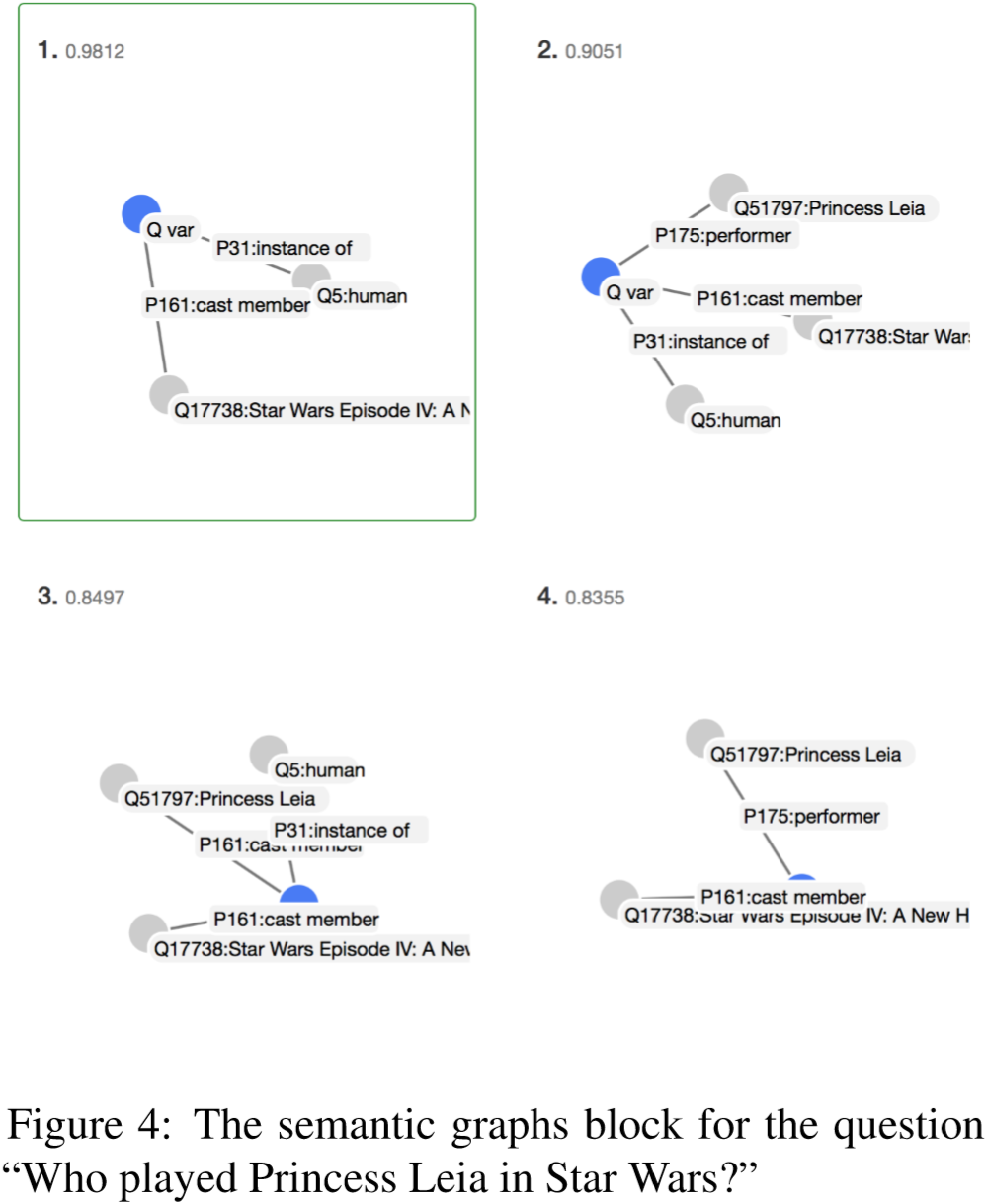

论文简述: 大多数知识库问答方法都是基于语义分析的。在本文中,我们提出为输入问题构造一个结构化的语义表示来协助调试问答系统。以前的工作主要集中在构建统一多个数据集的问答接口或评估框架。我们主要目标是在个别实例(问题)上实现模型预测的交互调试,并简化人工错误分析。我们的交互界面可以帮助研究人员了解一个特定模型的缺点,定性地分析完整的处理流程并比较不同的模型。

8、TILE: The combination of context information to enhance simple question answering

Author: Zhaohui Chao • Lin Li

Paper: https://arxiv.org/pdf/1810.04000v1.pdf

Code: None

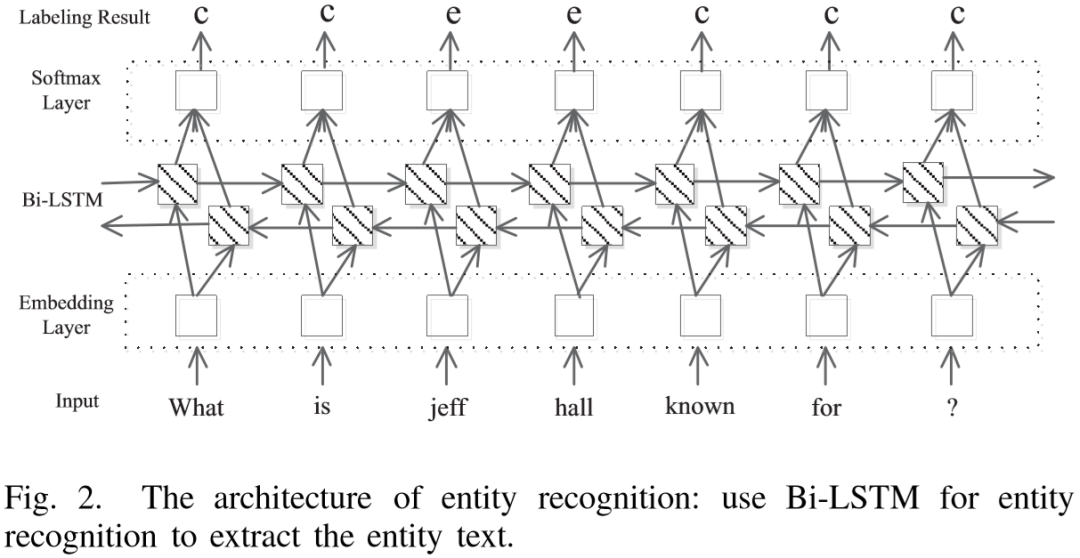

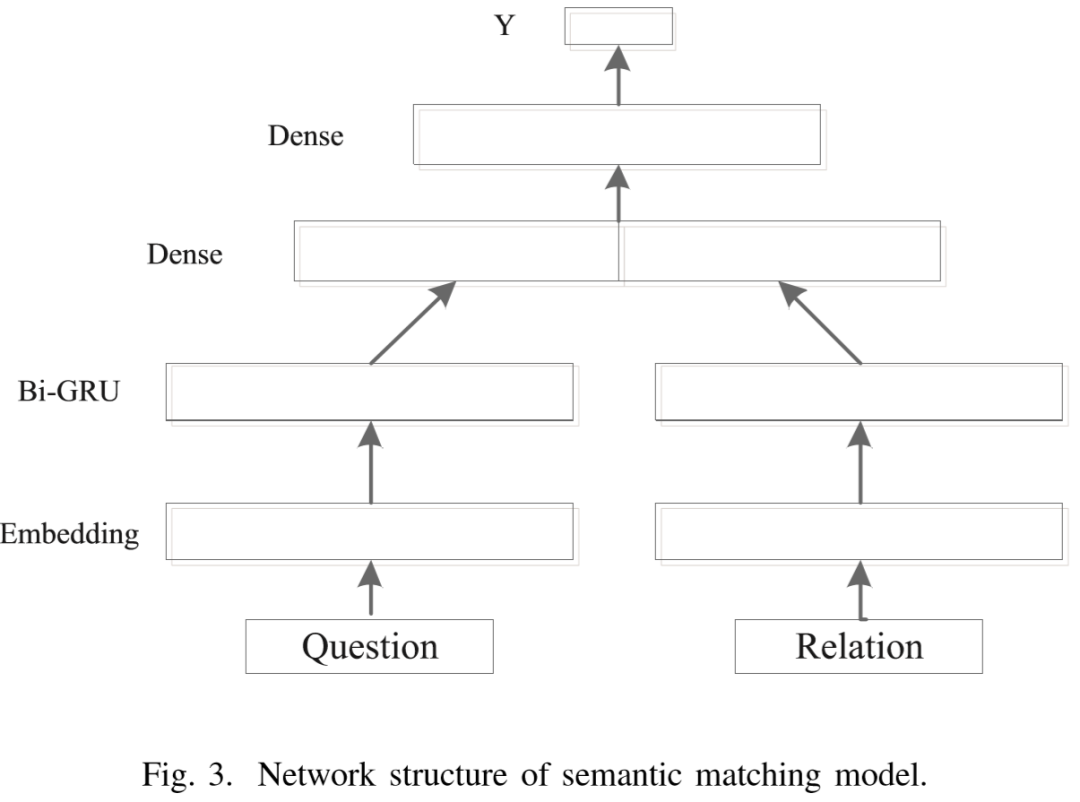

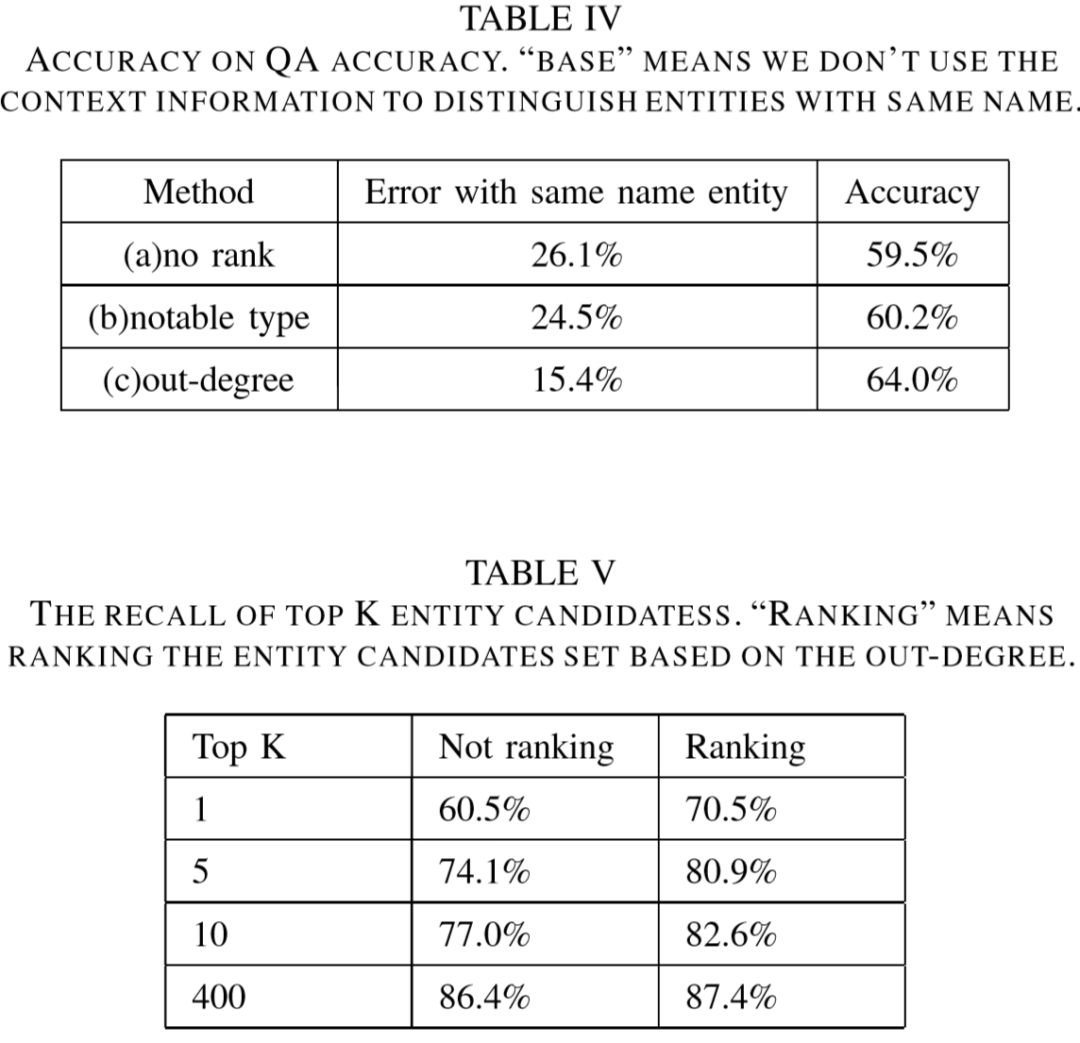

论文简述: 随着知识库的快速发展,基于知识库的问题回答已经成为一个研究热点。本文的研究重点是基于知识库的单点模拟问题的回答。建立了一个问答系统,研究了上下文信息对事实选择的影响,如实体的显著类型等。实验结果表明,上下文信息可以提高简单问题的回答结果。

学术圈

长按识别下方二维码

长按识别下方二维码 关注我们

关注我们

资料整理不易,帮忙点个【赞】、【在看】吧

本文分享自微信公众号 - AINLPer(gh_895a8687a10f)。

如有侵权,请联系 support@oschina.cn 删除。

本文参与“OSC源创计划”,欢迎正在阅读的你也加入,一起分享。

来源:oschina

链接:https://my.oschina.net/u/3952048/blog/4473219