Spark集群环境部署

一、 Spark集群环境部署

1、Spark安装包下载地址:http://spark.apache.org/doenloads.html

2、准备工作:Spark程序包

3、配置环境变量

(1)对配置文件.bash_profile进行修改,在文件末尾添加以下内容

并使新配置的环境变量立即生效

(2)配置spark文件

(3)配置slaves文件

4、将Master主机上的/home/admin/spark文件夹复制到各个节点上在Master主机上分别执行如下命令

二、启动spark集群

1、启动Hadoop集群

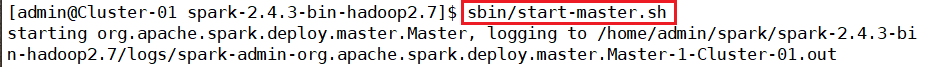

2、启动Master节点

3、启动所有Slave节点

4、通过访问地址http://192.168.10.111:8080来查看spark独立集群管理器的集群信息

5、启动spark-shell

三、关闭spark集群

分别关闭Master节点、Worker节点和Hadoop集群

四、编写Spark应用程序

1、编写hello.txt文件,上传到hdfs集群

输入以下指令,运行一个WordCount词频统计

如有想法,欢迎评论!

转载请标明出处:Spark集群环境部署

文章来源: https://blog.csdn.net/weixin_44495678/article/details/91346125