机器学习实用指南:如何从数据可视化中发现数据规律?

点击上方“AI有道”,选择“置顶”公众号

重磅干货,第一时间送达

本系列为《Scikit-Learn 和 TensorFlow 机器学习指南》的第四讲。上文请见下面这篇文章:

目前为止,我们已经对数据有了初步的认识,大体上明白了我们要处理的数据类型。现在,我们将进入更深入的研究。

首先,确保已经划分了测试集并放置一边,我们只会对训练集进行操作。另外,如果训练集很大,可以从中采样一些作为探索集(exploration set),方便进行快速处理。在我们这个例子中,数据集比较小,所以直接在训练集上处理即可。我们还要创建一个训练集的复制副本,这样就不会改动原来的训练集了。

housing = strat_train_set.copy()1. 地理数据可视化

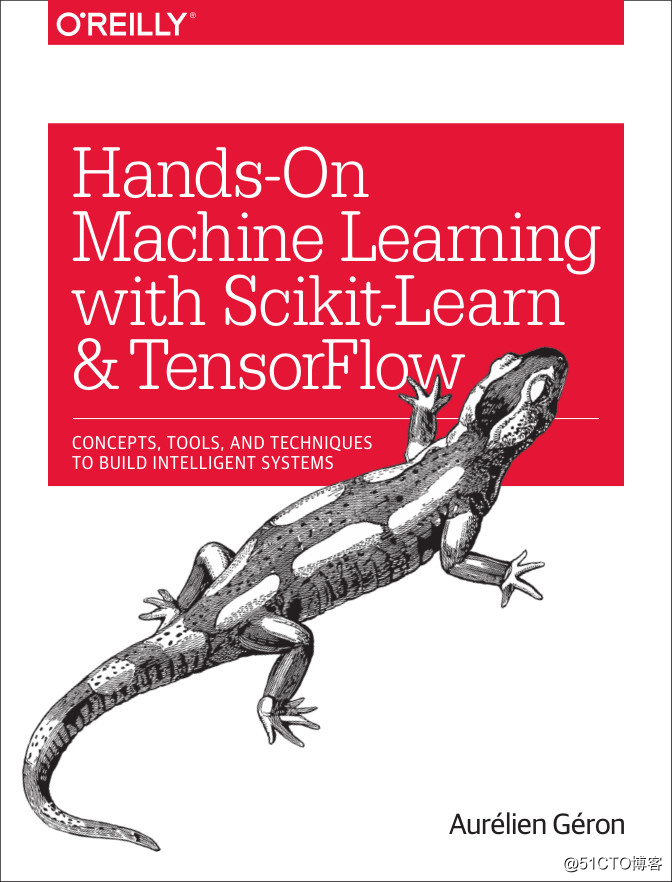

因为数据集中包含了地理位置信息(经纬度),所以创建所有地区的散点图来可视化数据是个好主意(如下图所示)。

这看起来有点像加州,但是很难看出任何规律。我们设置参数 alpha = 0.1,这样就更容易看出数据点的密度了(如下图所示)。

housing.plot(kind="scatter", x="longitude", y="latitude", alpha=0.1)

现在,我们可以很清晰地看出这些密度较大的区域了。

通常来说,人类的大脑非常善于发现图片中的模式,但是也需要使用一些可视化参数来让这些模式更加突出。

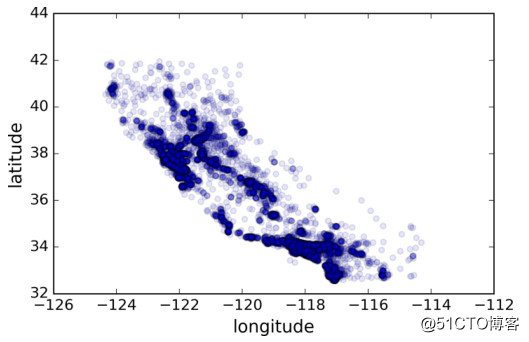

接下来,我们来看一下房屋价格(如下图所示)。其中,圆的半径代表地区人口(参数 s),圆的颜色代表房价(参数 c)。我们将使用预先定义好的颜色图 jet(参数 cmap),颜色范围从蓝色(低房价)到红色(高房价)。

housing.plot(kind="scatter", x="longitude", y="latitude", alpha=0.4,

s=housing["population"]/100, label="population", figsize=(10,7),

c="median_house_value", cmap=plt.get_cmap("jet"), colorbar=True,

sharex=False)

plt.legend()

save_fig("housing_prices_scatterplot")

注意,参数 `sharex=False` 修复了显示 x 轴和 legend 不显示的 bug。感谢 Wilmer Arellano 给的建议。出处:https://github.com/pandas-dev/pandas/issues/10611。

这张图显示出房价与地理位置(例如沿海)和人口密度关系很大,这一点你可能早就知道。可以使用聚类算法检测主要的聚集,增加新的特征测量到聚类中心的距离。尽管加州北部沿海地区的房价并不高,但是 ocean_proximity 属性仍然非常有用。总的来说,预测房价并不是使用一个简单规则就行的。

2. 寻找关联性

因为数据集不是很大,我们可以使用 corr() 方法直接计算任意两个属性的标准相关系数(也称皮尔逊相关系数)。

corr_matrix = housing.corr()现在,我们来看一下每个属性与房价中位数的相关系数分别是多少:

corr_matrix["median_house_value"].sort_values(ascending=False)median_house_value 1.000000

median_income 0.687170

total_rooms 0.135231

housing_median_age 0.114220

households 0.064702

total_bedrooms 0.047865

population -0.026699

longitude -0.047279

latitude -0.142826

Name: median_house_value, dtype: float64

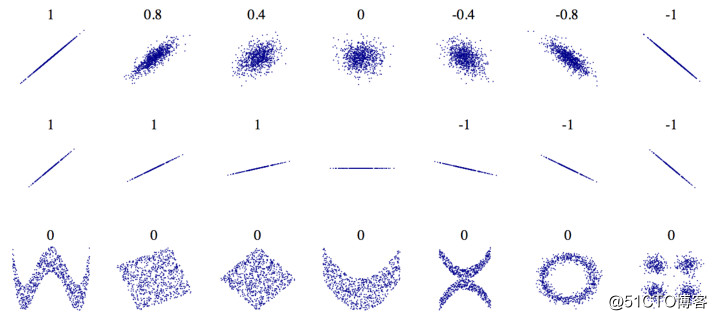

相关系数范围在 [-1, 1] 之间,越接近 1 表示正相关性越强,例如房价中位数与收入中位数。相关系数越接近 -1 表示负相关性越强。你可以看到房价中位数与维度呈现负相关性(数据显示越往北方,房价呈下降趋势)。最后,相关系数接近 0 表示无线性相关。下图展示了 x 轴与 y 轴对应数据的相关系数。

相关系数仅仅测量的是线性相关性(如果 x 增大,y 也同样增大或减小),可能完全忽略非线性关系(例如,x 在 0 附近,y 会增大)。注意,上图中最下面的那几张图表示的都是相关系数为零的情况,但是它们是非线性相关。第二行展示的几个图形相关系数为 1 或 -1,注意与直线的斜率无关。

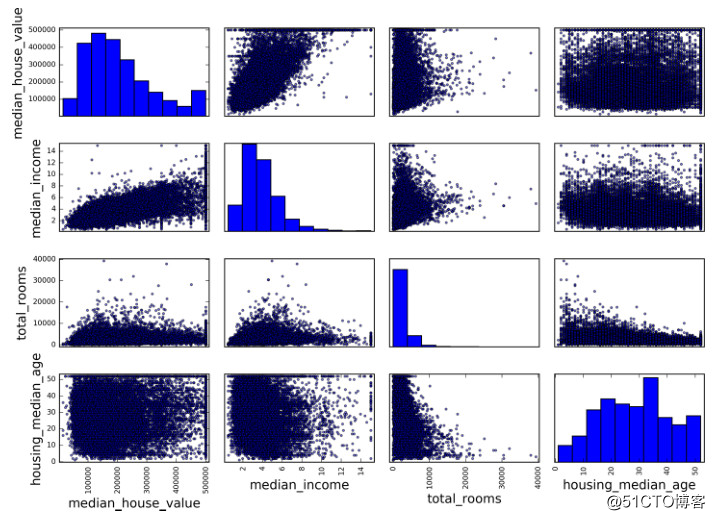

另外一种检查不同属性特征之间的相关系数的方法是使用 Pandas 的 scatter_matrix 函数。它将对每个数值属性与其它所有数值属性的相关性进行作图。因为现在有 9 个数值属性,总共有 9x9=81 个图,页面放不下这么多。所以,我们只选择几个与房价中位数关系较大的属性来作图。

from pandas.tools.plotting import scatter_matrix

attributes = ["median_house_value", "median_income", "total_rooms",

"housing_median_age"]

scatter_matrix(housing[attributes], figsize=(12, 8))

上图中,主对角线对应的相关系数全是直线(自己与自己的相关系数始终为 1),作图没有实质意义,因此显示的实际上是每个属性的柱状图。关于其它选项设置,可以参阅 Pandas 的文档。 看起来,最有可能用来预测房价中位数的属性是收入中位数,让我们把该图放大来看:

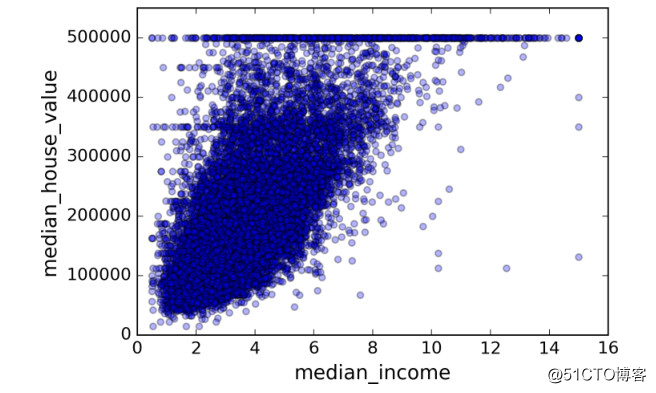

housing.plot(kind="scatter", x="median_income", y="median_house_value",

alpha=0.1)

这张图说明了几点:第一,相关性较强。你可以清楚看到数据点整体呈上升趋势,并不分散。第二,我们之前提过的价格上限 $500,000 呈现一条水平直线。同样在 $450,000、$350,000 和 $280,000 的位置也呈现了较弱的水平直线。在训练模型的时候最好移除这些样本点,防止算法学习到这些不好的数据。

3. 尝试结合不同的属性

希望前面的章节给了你一些探索数据、获取规律的方法。你发现了一些数据怪癖,在把数据放入机器学习算法之前,将其清除。你也发现了不同属性之间的相关性,尤其是与目标属性的相关性。你也注意到有些属性呈现长尾分布,可以进行转换处理(例如计算它们的对数)。当然,不同项目的处理方法并不完全相同,但是大致思路是类似的。

在准备数据给机器学习算法之前,你还可以尝试进行不同的属性组合。例如,如果你不知道地区有多少户,只知道地区总的房间数也没什么作用。你最想知道的是每户有多少房间。类似地,知道卧室数量也没什么用,你可能需要将其与房屋数量进行比较。还有,每户人口数应该也比较重要。下面,我们来创建这些属性:

housing["rooms_per_household"] = housing["total_rooms"]/housing["households"]

housing["bedrooms_per_room"] = housing["total_bedrooms"]/housing["total_rooms"]

housing["population_per_household"]=housing["population"]/housing["households"]

现在,我们再来看一下相关矩阵:

corr_matrix = housing.corr()

corr_matrix["median_house_value"].sort_values(ascending=False)

median_house_value 1.000000

median_income 0.687170

rooms_per_household 0.199343

total_rooms 0.135231

housing_median_age 0.114220

households 0.064702

total_bedrooms 0.047865

population_per_household -0.021984

population -0.026699

longitude -0.047279

latitude -0.142826

bedrooms_per_room -0.260070

Name: median_house_value, dtype: float64

看起来还不错!bedrooms_per_room 属性与房价中位数的相关性比单独的 total_rooms 和 total_bedrooms 与房价中位数的相关性更大。可以看出,bedroom/room 比值越小,房价越高。rooms_per_household 属性也比 total_rooms 包含了更多的信息——显然,房屋越大,价格就越高。

这一轮的探索不一定要非常完备。重要的是正确开始并快速发现一些规律,这将帮助你得到第一个合理的原型。这是一个迭代的过程:一旦你得到一个原型开始运行,你就可以分析它的输出,发现更多规律,然后回过头来继续探索数据,不断优化模型。

【推荐阅读】

来源:oschina

链接:https://my.oschina.net/u/4348626/blog/4812077