1 深度学习概念

2006年,Geoffery Hinton在《Science》和相关期刊上发表了论文,首次提出了“深度信念网络”的概念。具体是利用预训练的方式缓解了局部最优解的问题,将隐藏层增加到了7层,实现了真正意义上的“深度”。 他给多层神经网络相关的学习方法赋予了一个新名词--“深度学习”。很快,深度学习在语音识别领域暂露头角。接着,2012年,深度学习技术又在图像识别领域大展拳脚。在这之后,关于深度神经网络的研究与应用不断涌现。

2 神经网络分类

神经网络的分类主要有以下几种:DNN(深度神经网络)、RNN (循环神经网络)、CNN(卷积神经网络)、ResNet(深度残差)、LSTM之外,还有很多其他结构的神经网络 。

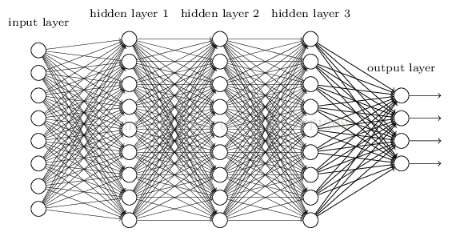

DNN:

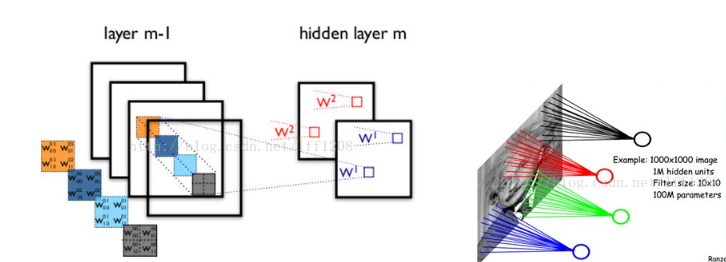

为了克服梯度消失,ReLU、maxout等传输函数代替了sigmoid,形成了如今DNN的基本形式。结构跟多层感知机一样,如下图所示. 我们看到全连接DNN的结构里下层神经元和所有上层神经元都能够形成连接,从而导致参数数量膨胀。假设输入的是一幅像素为1K*1K的图像,隐含层有1M个节点,光这一层就有10^12个权重需要训练,这不仅容易过拟合,而且极容易陷入局部最优。

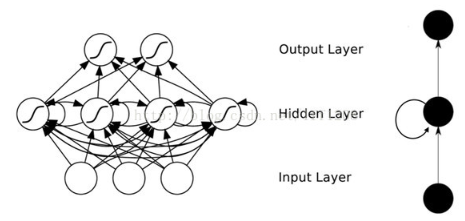

RNN:

DNN无法对时间序列上的变化进行建模。然而,样本出现的时间顺序对于自然语言处理、语音识别、手写体识别等应用非常重要。为了适应这种需求,就出现了循环神经网络RNN。在RNN中,神经元的输出可以在下一个时间段直接作用到自身,即第i层神经元在m时刻的输入,除了(i-1)层神经元在该时刻的输出外,还包括其自身在(m-1)时刻的输出!表示成图就是这样的:

CNN:

由于图像中存在固有的局部模式(如人脸中的眼睛、鼻子、嘴巴等),所以将图像处理和神将网络结合引出卷积神经网络CNN。CNN是通过卷积核将上下层进行链接,同一个卷积核在所有图像中是共享的,图像通过卷积操作后仍然保留原先的位置关系。

以上即是神经网络的主要分类,当然还有其他类型,这里不再介绍。

预告:下篇将讲解CNN结构,主要介绍卷积层,池化层以及全连接层的概念示例。

原创不易,转载请附地址: https://my.oschina.net/ffintell/blog/3212243

(示例图片来源网络,如有侵权,联系删除)

来源:oschina

链接:https://my.oschina.net/ffintell/blog/3212243